Big Data, Predictive Analytics und Machine Learning sind zu allgegenwärtigen "buzzwords" geworden – die Geschäftsmodelle und die Gesellschaft insgesamt revolutionieren sollen. Das Ziel des Einsatzes von Big-Data-Methoden und Datenanalysen liegt auf der Hand. Es geht um die Vermessung der Welt, der Kunden, dem Erstellen von Persönlichkeitsprofilen und der Voraussage in Echtzeit aus immer mehr Daten [vgl. vertiefend Eicher/Romeike 2016 sowie Jackmuth 2018, S. 366 f.]. Die Datenanalyse analysiert und visualisiert mit Hilfe statistischer Methoden Informationen aus großen Datenmengen. Der vorliegende Beitrag liefert einen Überblick über die Nutzung der Datenanalyse und einiger hieraus entwickelter Werkzeuge zur Betrugserkennung und Risikofrüherkennung.

Betrügern auf der Spur

Bereits im Jahr 1881 entdeckte der Astronom und Mathematiker Simon Newcomb während seiner Arbeit mit Logarithmenbüchern, dass diese auf den Anfangsseiten viel abgegriffener und abgenutzter waren als auf den hinteren Seiten. Diese Gesetzmäßigkeit der Verteilung der Ziffernstrukturen von Zahlen in empirischen Datensätzen wurde von ihm im "American Journal of Mathematics" publiziert. So traten Zahlen mit der Anfangsziffer 1 rund 6,6-mal so häufig auf wie Zahlen mit der Anfangsziffer 9. Heute ist diese Gesetzmäßigkeit als Benfordsche Gesetz oder Newcomb-Benford’s Law (NBL) bekannt.

Diese Gesetzmäßigkeit der Zahlen verwendet man heute in der Praxis, um beispielsweise Manipulationen im Rechnungswesen, bei Steuererklärungen oder Datenmanipulationen in der Wissenschaft zu erkennen. So wurde beispielsweise das "kreative" Rechnungswesen bei den US-Unternehmen Enron und Worldcom mit Hilfe der NBL-Methode aufgedeckt. Allerdings liefert das Benfordsche Gesetz in der Praxis lediglich eine erste Indikation – keinesfalls einen Beweis. In der Zwischenzeit existieren komplexere und bessere Methoden, die zuverlässiger ans Ziel führen.

Artificial-Intelligence-Methoden, beispielsweise Machine Learning, werden unter Nutzung von großen Datenmengen (Big Data) bereits im Risikomanagement und in der Fraud-Erkennung erfolgreich eingesetzt. So kann beispielsweise die Prognosegüte von Risikomodellen signifikant verbessert werden, insbesondere bei der Identifikation von nicht-linearen Zusammenhängen zwischen Risikofaktoren und Risikoereignissen.

PDCA der Datenanalytik: Modell der integrierten Datenanalytik

Durch das hypothesenfreie Arbeiten bei der Ermittlung von Tathergängen kann es schwierig sein, insbesondere Kennzahlen und messbare Ziele zu formulieren. Im wahren Leben heißt das zumeist: "Es sollen so viele Fälle wie möglich identifiziert werden". Und genau darin besteht die analytische Herausforderung. Sind in der Grundgesamtheit justiziable Ausreißer und wenn ja, in welcher Menge?

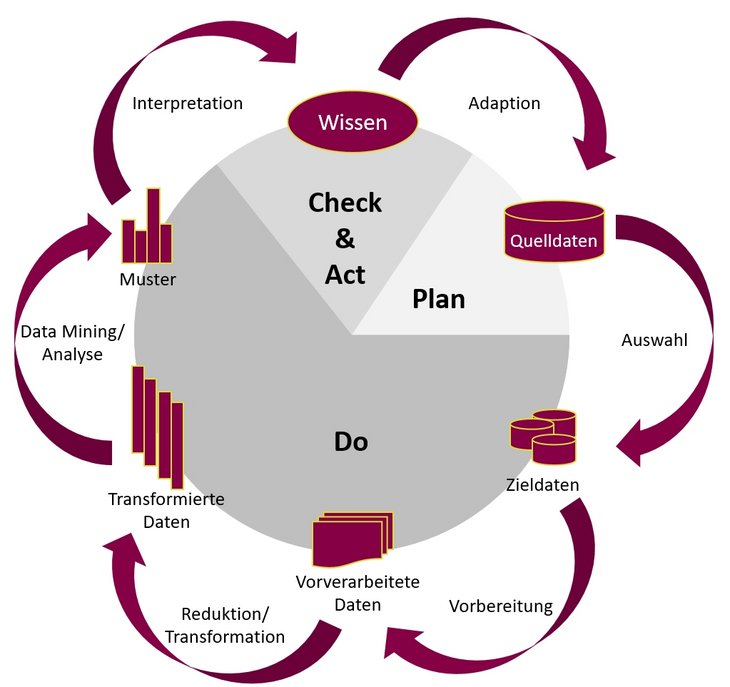

Es sollten also Möglichkeiten gefunden werden, die Ziele zu operationalisieren und messbar zu machen. Eine Kombination aus verschiedenen Methoden hat sich daher in der Praxis unter Berücksichtigung von Einsatzformen – anlassbezogener, permanenter/präventiver und explorativer Analyse – in Verbindung mit dem PDCA-Zyklus und dem KDD-Prozess (Knowledge Data Discovery- Prozess) als Baukasten bewährt [vgl. vertiefend Fayyad/Piatetsky-Shapiro/Smyth 1996, S. 37 ff.]. Dies ermöglicht eine Planung, die Durchführung und anschließende Bewertung und Optimierung von Datenanalysen nach einem fest definierten und strukturierten Vorgehen [vgl. Jackmuth 2018, S. 364].

Das Vorgehen ist in Tab. 01 [vgl. Jackmuth 2018, S. 365] zusammengefasst.

Plan (Planung)

| Mithilfe von Expertenwissen wird in der ersten Phase eine Analyse der Ist-Situation durchgeführt. Ziel ist es, Hypothesen zu definieren oder Themengebiete für hypothesenfreie Analysen festzulegen. Datenquellen werden lokalisiert und Vortests zur Eignung der Datenqualität für die Analyse durchgeführt. Zusätzlich werden Ziele bzw. Erwartungen für die Analyse gesetzt. |

Do (Umsetzung)

| Die Daten werden für die Analyse aufbereitet und mithilfe von Analyseverfahren (Data Mining, maschinellen Lernen o.ä.) ausgewertet. |

Check (Überprüfung)

| Die durch die Umsetzung erhaltenen Ergebnisse werden überprüft und validiert. Auf Grundlagen von Prozesswissen werden Zusammenhänge erläutert und die angewendete Methodik auf Verbesserungspotentiale geprüft. |

Act (Verbesserung)

| Die aus der Überprüfung gemachten Erfahrungen werden für die Umsetzung genutzt. Der Zyklus wird erneut durchlaufen wiederholt, bis zufriedenstellende Ergebnisse erreicht sind. |

Tab. 01: PDCA der Datenanalytik

Der KDD-Prozess, welcher aus fünf Schritten und damit verbundenen Inputs und Outputs besteht, lässt sich in der Praxis, wie in Tab. 01 dargestellt, an dem Standard-PDCA-Modell optimieren.

Integrierte Datenanalytik kann sich nicht auf die hypothesenfreie Analyse beschränken. Für eine professionelle Erkennung von Betrugsmustern hat sich in der Praxis die Nutzung von Prozesswissen und einer daraus abgeleiteten Hypothesenbildung bewährt.

"Solides kriminelles Denken" – also ein "von den Besten lernen", das heißt von den Tätern, hilft bei der Aufdeckung enorm.

Dies bedeutet ausdrücklich nicht, dass auf hypothesenfreie Algorithmen verzichtet werden soll, sondern sie sollen durch Hypothesen und weiteres Wissen unterstützt werden. Eine wichtige Eigenschaft des KDD-Prozesses ist, dass er nicht bei jedem Durchlauf linear und vollständig durchlaufen werden muss. Ein Abbruch und eine folgende Anpassung der vorangegangenen Prozessschritte sind möglich und sinnvoll: Durch eine Analyse wurde beispielsweise festgestellt, dass in den Daten auffällige Buchungen zu finden sind. Diese Buchungen wurden jeweils an verschiedene Bankkonten überwiesen. Viele dieser Bankkonten sind sogenannten Direktbanken zuzuordnen, die oft keinerlei Filialgeschäft haben und auf Drittanbieter zur Verifizierung von Neukunden angewiesen sind. Dokumentenfälschungen machen einige der Verifizierungsverfahren potenziell anfällig für Manipulationen. Für Täter bietet es sich also geradezu an, Direktbanken für die Zielkonten zu nutzen.

Nachdem dieses Merkmal bei den auffälligen Belegen identifiziert wurde, sollte es für weitere Analysen nutzbar gemacht werden. In die Quelldaten wird eine Liste mit den "Bankleitzahlen" von Direktbanken hinzugefügt und in die Zieldaten aufgenommen, der Prozessschritt "Auswahl" wurde also wiederholt, die folgenden Schritte entsprechend neu durchlaufen. Bei der "Transformation/ Reduktion" wurden die entsprechenden, an eine Direktbank gegangenen Belege gekennzeichnet und stehen für den Schritt "Data Mining/Analyse" zur Verfügung (siehe Abb. 01) [vgl. Jackmuth 2018, S. 366 f.].

Abb. 01: Prozess der integrierten Datenanalytik

Abb. 01: Prozess der integrierten Datenanalytik

Um diesen Erkenntnissen Rechnung zu tragen, kann man den KDD-Prozess in den PDCA-Zyklus einbetten. Ziel muss es sein, im Fraud Management in einen ständigen Prozess der Datenanalyse zu gelangen, um Probleme frühzeitig aufdecken zu können. Die Methoden stehen in diversen (teils sogar OpenSource-)Produkten zur Verfügung (zum Beispiel die ursprünglich an der Universität Konstanz entwickelte Analyseplattform unter www.knime.com). Dadurch ist es möglich, den Analyseprozess stetig zu verbessern und die Analyseergebnisse zu optimieren.

Methoden und Werkzeuge

Regelbasierte Filtermethodik

Von Seiten des Berufsverbandes der IT-Revision, der Information Systems Audit and Control Association (ISACA), wird seit dem Jahr 1978 (!) das Konzept des Control Continuous Monitoring (CCM) gefordert. Die Vorgehensweise erlaubt, die Performance von einem oder mehreren Prozessen, Systemen oder Datentypen zu überwachen. Im Sinne der forensischen Überwachung liegt hier ein prozessuales Vorgehen zugrunde [vgl. Jackmuth 2012, S. 632]. In einem Zeitalter, wo Microsoft® Excel-Tools gerade einmal 16.384 Zeilen verarbeiten konnten, bestand hier nur die Möglichkeit intelligente Datenfilter zu setzen. Dies setzt allerdings auf Seiten des Analysten voraus, dass die Filter auch die auftretenden Cases abdecken.

Insofern sind die Geldströme, welche ein Unternehmen verlassen, das entscheidende Kriterium. Täter sind immer "nah am Geld" – zumindest in elektronischer Form. Inwieweit dabei die Datenanalytik als präventiv eingestuft wird, mag der jeweiligen Blickrichtung überlassen werden. Softwarehersteller verkaufen gerne präventive Tools, auch wenn der regelbasierte Ansatz erst eine Aufdeckung nach dem ersten Musterfall gewährleistet.

Data Mining

Data Mining lässt sich übersetzen mit den Begriffen Datengewinnung oder Datenschürfen. Während die häufig in den Unternehmen eingesetzten Methoden auch heute noch eher einem regelbasierten Absatz folgten, dient Data Mining nicht dazu, bereits bekannte Hypothesen zu überprüfen, sondern völlig neue Dinge zu entdecken, die sich in den Tiefen der Datenbank verborgen haben. Usama Fayyad, einer der Väter der Methodik, beschrieb dies wie folgt: Data Mining ist "die nicht triviale Entdeckung gültiger, neuer, potenziell nützlicher und verständlicher Muster in großen Datenbeständen." ("Knowledge Discovery in Databases describes the non-trivial process of identifying valid, novel, potentially useful, and ultimately understandable patterns in data.") [Fayyad/Piatetsky-Shapiro/Smyth 1996, S. 6].

Damit sollen Methoden (als Beispiel seien hier SOM, Self Organization Maps, als Typus eines neuronalen Netzes benannt) systematisch auf einen großen Datenbestand mit dem Ziel der Mustererkennung angewandt werden, um verborgene Regeln aufzuspüren, Muster und Strukturen zu erkennen sowie Abweichungen und statistische Auffälligkeiten nachzuweisen.

Text Mining

Bei Sonderuntersuchungen kommt es oftmals zu der Problematik, dass mehrere hundert Dokumente gesichtet, kategorisiert und wichtige Informationen lokalisiert werden müssen. Unterstützen kann dabei die Verwendung von Text Mining. Unter dem Begriff Text Mining sammeln sich eine Vielzahl statistischer und linguistischer Methoden und Algorithmen, die dazu dienen, Sprache für einen Computer verständlich und auswertbar zu machen.

Im Rahmen von Sonderuntersuchungen verwenden wir regelmäßig Analysen des Tools KNIME, um beispielsweise mehrere tausend Seiten innerhalb diverser Dokumente auf bereits bekannte Personen zu untersuchen.

Datenanalyse zur Betrugserkennung und Risikofrüherkennung

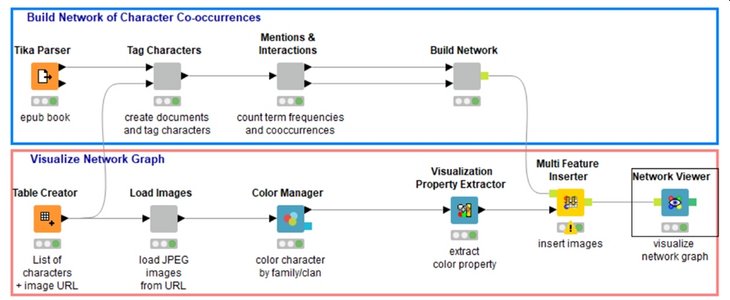

Die Konstellationen und entsprechenden Verbindungen zwischen Personen lassen sich automatisiert ermitteln und damit neue Zusammenhänge offenbaren. Die genutzte Methodik bedient sich der bereits beschriebenen Graphentheorie bzw. der sozialen Netzwerkanalyse [vgl. Romeike 2018, S. 110 ff.]. KNIME ist nach einem Workflow-Prinzip aufgebaut (siehe Abb. 02). Die Daten durchlaufen jeweils verschiedene Knoten und werden in der Funktionalität des Knotens bearbeitet [vgl. Jackmuth 2018, S. 402].

Abb. 02: Ausschnitt aus dem KNIME-Workflow

Abb. 02: Ausschnitt aus dem KNIME-Workflow

Fazit und Empfehlungen

Ausgehend von dem Fraud-Baum "Occupational Fraud and Abuse Classification System" des Berufsverbandes ACFE lassen sich drei Hauptkategorien von Wirtschaftskriminalität in Unternehmen ausmachen [vgl. Kopetzky/Wells 2012, S. 52]:

- Vermögensmissbrauch,

- Korruption und Bestechung,

- Finanzdatenfälschung.

Wenn diese Faktoren aber so klar definiert sind, muss ein Risiko- und Fraud Management darauf ausgerichtet werden, möglichst die Ursachen (Causes) zu identifizieren. Im konkreten Fall geht es um die Analyse der Ursachen, bevor überhaupt die Straftat begangen wurde. Budgets für Prävention zur Verfügung zu stellen ist sicherlich sinnvoller als Ermittlungskosten zu tragen. Parallel muss in den Unternehmen das Wissen verstärkt werden, die aufgezeigten Methoden wirkungsvoll einzusetzen. Das frühzeitige Identifizieren von schwachen Signalen (weak signals) und Ursachen (causes) mit Hilfe geeigneter Methoden spart ebenso Kosten [vgl. hierzu auch Romeike 2019a].

Aktuell wird ausgehend von Ansätzen der Hochschule St. Gallen das aus dem letzten Jahrhundert stammende Denkmodell des Fraud-Triangels ergänzt. In diversen Standards findet man Formulierungen wie "Wirtschaftskriminalität ist dann zu erwarten, wenn sowohl eine Motivation und Gelegenheit zur Durchführung als auch eine innere Rechtfertigung für die Handlung vorliegt". Dieses Denkmodell ergänzt Schuchter zu einem Fraud Diamond – es gehören neben der Gelegenheit eben auch handwerkliche Fähigkeiten des Täters, wie beispielsweise das Umgehen von Vier-Augen-Prinzipien oder der kriminelle Zugriff auf IT-Systeme, zur erfolgreichen Tat.

Konkret gehören dazu diese Mechanismen zu kennen, zu wissen wie Täter "ticken" [vgl. vertiefend Schuchter 2012] und basierend auf dem rasanten Wachstum der verfügbaren Daten, in der Folge der Digitalisierung von Geschäftsmodellen wachsen, auch die Möglichkeiten zur Datenanalyse. Wir haben aufgezeigt, welchen Nutzen Unternehmen aus diesen Entwicklungen im Kontext Risikomanagement und Betrugserkennung ziehen können. Weitere Unterstützung bietet das Deep Learning als ein Teilbereich des Machine Learnings. Hierbei werden häufig Architekturen in Form von neuronalen Netzen genutzt. Deshalb werden Deep-Learning-Modelle häufig als tiefe neuronale Netze bezeichnet. [vgl. vertiefend Schmidhuber 2015 sowie Romeike 2019b].

Dies bedingt allerdings, dass Unternehmen ein neues Verständnis für Datenanalyse entwickeln und die Chancen hieraus erkennen und nutzen. Die nächsten Jahre werden zeigen, dass sich Datenanalyse-Know-how zu einer wesentlichen Schlüsselkompetenz (nicht nur) für Risikomanager und Compliance-Experten entwickeln wird. Rein fachlich-methodische Quants und Risikomanager wird es weniger geben; stattdessen sind Quant Developer und Data Manager/Scientists die Risikomanager der Zukunft. An ihnen wird es liegen, robuste Datenanalyse-Modelle mit hoher Prognosegüte zu entwickeln.

Literatur

- Fayyad, Usama/Piatetsky-Shapiro, Gregory/Smyth, Padhraic [1996]: From Data Mining to Knowledge Discovery in Databases, in: AI Magazine, American Association for Artificial Intelligence, California, USA, S. 37-54.

- Jackmuth, Hans-Willi [2012]: Datenanalytik im Fraud Management – Von der Ad-Hoc- Analyse zu prozessorientiertem Data-Mining, in: de Lamboy, C./Jackmuth, H.-W./ Zawilla, P. (Hrsg.): Fraud Management – Der Mensch als Schlüsselfaktor gegen Wirtschaftskriminalität, Frankfurt am Main 2012, S. 627-662.

- Jackmuth, Hans-Willi/Parketta, Isabel [2013]: Methoden der Datenanalytik in: de Lamboy, C./Jackmuth, H.-W./Zawilla, P. (Hrsg.): Fraud Management in Kreditinstituten, Frankfurt am Main 2013, S. 595-620.

- Jackmuth, Stefan [2018]: Integrierte Datenanalytik im Fraud Management, in: de Lamboy, C./Jackmuth, H.-W./Zawilla, P. (Hrsg.): Fraud und Compliance Management – Trends, Entwicklungen, Perspektiven, Frankfurt am Main 2018, S. 345-407.

- Kopetzky, Matthias/Wells, Joseph T. [2012]: Wirtschaftskriminalität in Unternehmen. Vorbeugung & Aufdeckung, 2. Auflage, Wien 2012.

- Newcomb, Simon [1881]: Note on the Frequency of the Use of different Digits in Natural Numbers. In: American journal of mathematics (Amer. J. Math.), Baltimore 4.1881, S. 39-40.

- Romeike, Frank [2017]: Predictive Analytics im Risikomanagement – Daten als Rohstoff für den Erkenntnisprozess, in: CFO aktuell, März 2017.

- Romeike, Frank [2018]: Risikomanagement, Springer Verlag, Wiesbaden 2018.

- Romeike, Frank [2019]: Risk Analytics und Artificial Intelligence im Risikomanagement, in: Rethinking Finance, Juni 2019, 03/2019, S. 45-52.

- Romeike, Frank [2019a]: Toolbox – Die Bow-Tie-Analyse, in: GRC aktuell, Ausgabe Februar 2019, 01/2019, S. 39-44.

- Romeike, Frank [2019b]: KI bei Datenschutz und Compliance, in: Handbuch Künstliche Intelligence, Bonn 2019, Internet: handbuch-ki.net

- Schmidhuber, Jürgen [2015]: Deep learning in neural networks: An overview, in: Neural Networks, 61, 2015, S. 85.

- Schuchter, Alexander [2012]: Perspektiven verurteilter Wirtschaftsstraftäter: Gründe ihrer Handlungen und Prävention in Unternehmen, Frankfurt am Main 2012.

- Schuchter, Alexander [2018]: Wirtschaftskriminalität und Prävention. Wie Führungskräfte Täterwissen einsetzen können, Wiesbaden 2018.

Autoren:

Hans-Willi Jackmuth | Geschäftsführender Gesellschafter | addResults GmbH | Rösrath / Köln

Frank Romeike | Geschäftsführender Gesellschafter | RiskNET GmbH | Mitglied des Vorstands der Association for Risk Management & Regulation | München und Frankfurt am Main

[Quelle: FIRM Jahrbuch 2020, S. 71-74]