Risikomanager sind gefordert, unerwartete und extreme Situationen erfolgreich zu meistern. Eine allgegenwärtige, scheinbar perfekte Technik trägt dazu bei, eine Illusion der Gewissheit und Kontrollierbarkeit mit klaren Verhaltensregeln aufzubauen. Doch kann es diese Gewissheit allgemein nicht geben. Wie können Risikomanager ungewissen Extremsituationen begegnen? Die Standardmethoden des Risikomanagements lassen die Berechnung von Risiken einfach erscheinen. Die Finanzkrise hat gezeigt, dass diese Methoden jedoch nicht ausreichen. Risikomanager benötigen ein Instrumentarium, das Ihnen hilft, Risiken in kurzer Zeit kompetent und intelligent einzuschätzen. Die Analyse von Risikoszenarien und die Bewertung von extremen Ereignissen mit statistischen Methoden sind Ergänzungen zum klassischen Managementansatz.

Das für Extremereignisse blinde Risikomaß

Risiken begleiten unser Leben. In der Unternehmensführung ist das Management von Risiken eine wesentliche Aufgabe. Im Risikomanagementprozess werden Verantwortlichkeiten für die Erfassung, Bewertung und Steuerung von Risiken zugeordnet. Dadurch soll gewährleistet werden, dass Risiken keine existenzbedrohenden Überraschungen sind. Das funktioniert jedoch nur insoweit, als Risiken kalkulierbar sind. Es ist daher natürlich, mathematische oder statistische Berechnungsformeln für Risiken zu verlangen.

Zunächst im Bankmanagement für die Bewertung von Marktrisiken – später dann auch für die Abschätzung von operationellen Risiken in der Industrie – wurde in den 90er Jahren der Value-at-Risk als Standardrisikomaß eingeführt. Ursprünglich wurde das Risikomaß von der Investmentbank JP Morgan entwickelt und fand eine rapide Verbreitung in der Finanzindustrie. Die grundlegende Idee der Erfinder des Value-at-Risk war, Portfoliobesitzer vor adversen Marktbedingungen und großen Verlusten zu schützen.

Das Ende der letzten Dekade war von einer signifikanten Instabilität der weltweiten Märkte mit extremen Wertverlusten gezeichnet, die deutlich aufzeigten, dass der Value-at-Risk als Standardrisikomaß die Anforderungen an ein wertschonendes Risikomanagement nicht erfüllen konnte. Dies hat zu heftiger Kritik an den existierenden Risikomanagement-Systemen geführt und die Suche nach besseren Methodologien motiviert, die mit seltenen und extremen Ereignissen mit existenzbedrohenden Konsequenzen zurechtkommen. Die Kritik beruht im Wesentlichen auf zwei grundsätzlichen Eigenschaften des Value-at-Risk. Erstens beschreibt er eine obere Verlustgrenze, die mit einer gewissen Wahrscheinlichkeit nicht überschritten wird. Liegt der Value-at-Risk bei einem Konfidenzniveau von 99 Prozent beispielsweise bei 50 Millionen Euro, heißt das, dass mögliche Verluste mit 99-prozentiger Wahrscheinlichkeit in einem bestimmten Zeitraum diesen Betrag nicht überschreiten werden. Die Zahl sagt aber nichts darüber, wie hoch der Verlust bei außerordentlichen unvorhersehbaren Ereignissen tatsächlich werden kann. Zweitens setzt die Berechnung des Value-at-Risk beim Varianz-Kovarianz-Ansatz eine Normalverteilung der Daten voraus. Diese Annahme ist aber in der Regel nicht zutreffend, da man weiß, dass die Verteilungen von Zeitreihen von Risikofaktoren für wesentliche Risiken wie Markt-, Kredit-, operationelle und Rückversicherungsrisiken in der Regel einen sogenannten "fat tail" aufweisen. Das bedeutet, dass für die Steuerung von Risiken die Ausreißer einer Zeitreihe von Interesse sind.

Auch gängige Planungsmodelle in der Unternehmensführung stellen nicht selten auf die vereinfachten statistischen Konzepte der Normalverteilung ab (gemeint sind hier beispielsweise Trend-, Regressions- oder Varianzanalysen), genauso wie sie im traditionellen Risikomanagement Anwendung finden. So werden auf Basis historischer Beobachtungen Prognosemodelle entwickelt, die implizit den zentralen Grenzwertsatz anwenden. Dieser beschreibt das Verhalten einer Zeitreihe durch Mittelwerte und Abweichungen von Summen unabhängiger Beobachtungen. In betriebswirtschaftlichen Zusammenhängen wird immer wieder mit der Normalverteilung und dem zentralen Grenzwertsatz gerechnet. Häufig ist dies gerechtfertigt, denn normalverteilte Merkmalsausprägungen sind häufig: Technische Maße im Qualitätsmanagement, Nachfragedaten im Marketing, Kosten- und Leistungskennzahlen sind oft normalverteilt.

Die Normalverteilung hilft uns also, eine Vielzahl alltäglicher Probleme zu beschreiben und zu lösen. Im Risikomanagement ist man jedoch am Extremverhalten interessiert, beispielsweise wenn die notwendige Sicherheitsreserve einer Bank oder eines Versicherungsunternehmens festgelegt werden soll oder ein ausreichender Sicherheitspuffer in der Supply-Chain eines Industrieunternehmens bestimmt werden soll. Hier hilft es wenig zu wissen, wie hoch die durchschnittlichen möglichen Verluste eines Kreditportfolios, die durchschnittlichen Forderungen an eine Versicherung oder durchschnittliche Lieferverzögerungen von Lieferanten sind. Von Interesse für das Risikomanagement ist, wie groß ein solches Ereignis maximal sein kann.

Extremereignisse als Grundlage des Risikomanagements

Extremereignisse zeichnen sich dadurch aus, dass sie häufig auf einer Verkettung von Ereignissen basieren, die einzeln oft gut handhabbar wären. Die verheerende Ereigniskette des Atomunfalls von Fukushima zeigt dies deutlich. Die Havarie des Atomkraftwerks entstand durch das Zusammenwirken des starken Erdbebens im Pazifik, der dadurch ausgelösten Tsunami-Welle, die bei der Überschwemmung des Kraftwerks einen Stromausfall bewirkte, so dass es letztlich zu einer Kernschmelze in mehreren Reaktoren kam. Weniger bekannt ist, dass nur rund zehn Kilometer Entfernung von dem havarierten Kernkraftwerk ein weiteres Kernkraftwerk von der Naturkatastrophe schwer getroffen wurde. Doch eine "echte" Katastrophe konnte durch ein proaktives Management der extremen Risikosituation verhindert werden [vgl. Gulati/Casto/Krontiris 2014]. Lieferverzögerungen und Produktionsausfälle bei deutschen Unternehmen als weitere Folge der Katastrophe zeigen die Anfälligkeit der Versorgungsketten in der globalisierten Wirtschaft.

Risiken aus Extremereignissen wirken sich im Supply-Chain-Management besonders stark aus, was eine direkte Folge der Just-in-Time- beziehungsweise Just-in-Sequence-Produktion ist. In den letzten Jahren wurde durch politische Unruhen und Umweltkatastrophen die Stabilität der Supply-Chains von Unternehmen immer wieder auf die Probe gestellt. Das Abstellen auf Einzelereignisse erzeugt dabei eine Diskrepanz zwischen der vorherrschenden komplexen Bedrohungslage und der Risikowahrnehmung im Unternehmen und führt zur Illusion einer einfachen Handhabbarkeit von Risiken.

Um nicht blind den Auswirkungen solcher Extremereignisse entgegen zu stehen bedarf es – insbesondere in international tätigen Unternehmen – einer Berücksichtigung von Risiken aus Extremereignissen in das Risikomanagement. Dazu wird ein Instrumentarium für ein ganzheitliches Risikomanagement im Unternehmen benötigt, das über die zu stark vereinfachende Normalverteilung und den damit verbunden Value-at-Risk-Ansatz hinausgeht.

Ein möglicher Ansatz ist ein szenariobasiertes Risikomanagement, bei dem im Risikomanagementprozess mögliche – auch unwahrscheinliche – Szenarien entwickelt und gedanklich durchgespielt werden.

Szenariobasiertes Risikomanagement

Die Finanzbranche hat auf das Versagen der Risikomanagementsysteme in der Finanzkrise mit einer Vielzahl an Vorschlägen für neue Risikomess- und Risikomanagement-Methoden reagiert. Eine der ersten Anforderungen sowohl von aufsichtlicher als auch brancheninterner Seite war die Etablierung sogenannter Stresstests [vgl. European Banking Authority 2016]. Bei diesem Risikomanagement-Instrument gibt es wiederum eine Reihe unterschiedlicher Ansätze, von denen sich mittlerweile makroökonomische Stresstests als vielversprechendes Instrument zur Überprüfung der Widerstandfähigkeit sowohl einzelner Banken als auch des gesamten Bankensektors gegen adverse Marktbedingungen etabliert haben. Demzufolge werden diese Stresstest regelmäßig durchgeführt. Für den aktuellen im Jahr 2016 von 53 europäischen Banken durchzuführenden Stresstest hat die Europäische Bankenaufsichtsbehörde EBA im November 2015 die Methodik und die makroökonomischen Szenarien veröffentlicht [vgl. www.eba.europa.eu]. Die europaweit gleichermaßen anzuwendende Methodik, einheitliche Szenarien und eine abgestimmte Offenlegung sollen sicherstellen, dass die Ergebnisse kohärent und vergleichbar sind.

Das grundlegende Vorgehen bei einem makroökonomischen Stresstest ist einfach [vgl. Vgl. Thun/Prioux/Canamero 2013]: Ausgehend von einem geschlossenen makroökonomischen Szenario, das sowohl eine qualitative Beschreibung einer möglichen Entwicklung wesentlicher Märkte als auch deren Quantifizierung durch Prognosemodelle für realwirtschaftliche und finanzielle Kennzahlen beinhaltet, werden über einen vorgegebenen Zeitraum von einigen Jahren Auswirkungen auf die Qualität der Aktiva und die damit verbundenen möglichen Wertberichtungsbedarfe sowie weitere wesentliche Komponenten der Gewinn- und Verlustrechnung und des Eigenkapitals, abgeschätzt und daraus Risikokennzahlen – für Banken als wesentlichste Kennzahl die Core Equity Tier 1-Quote – simuliert.

Die Anwendung szenariobasierter Stresstests kommt einem Paradigmenwechsel in der Risikosteuerung von Banken gleich, fragt man doch nicht mehr nach der Wahrscheinlichkeit bestimmter Ereignisse. Ganz im Gegenteil: Durch die detailgetreue Beschreibung des makroökonomischen Szenarios wird das tatsächliche Eintreten des so spezifizierten Ereignisses immer unwahrscheinlicher. Es wird aber immer realistischer und bietet daher eine konkrete Basis für das gedankliche Durchspielen von Handlungsstrategien und die Formulierung von Gegenmaßnahmen. Auf der Basis von Risikoszenarien lassen sich Extremsituationen simulieren und eine Handlungsroutine etablieren, um im Ernstfall operative Risiken zu vermeiden.

Risikoszenarien lassen sich in allen Unternehmen in jedweder Industrie anwenden. Durch das Formulieren solcher Szenarien können Auswirkungen unerwarteter und extremer Ereignisse diskutiert und bewertet werden – selbst wenn sie unwahrscheinlich sind. Gerade solche Ereignisse erweisen sich häufig als Prüfungen der Flexibilität und Widerstandskraft eines Unternehmens. Denn die meisten Probleme tauchen nicht unversehens in voller Größe aus dem Nichts auf. Vielmehr häufen sich über einen längeren Zeitraum die Hinweise auf kleine, unerwartete Ereignisse, die allmählich zu ständigen Begleitern und demzufolge im Tagesgeschäft ignoriert werden. Bei Fehleranalysen werden einfache und vereinfachende Diagnosen akzeptiert. Bei einem geringen äußeren Anlass kann es dann plötzlich passieren, dass eine Verkettung kleiner Fehler zu einem existenzbedrohenden Szenario wird.

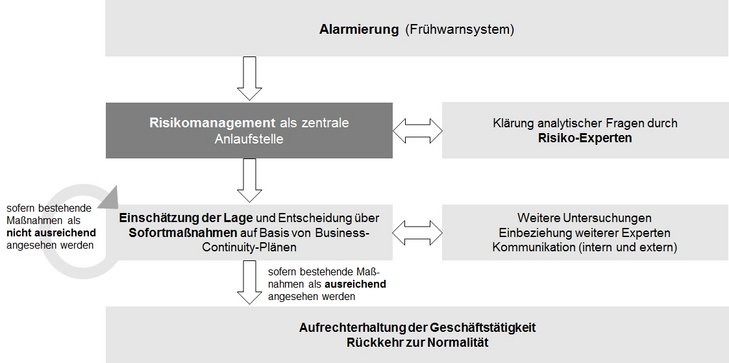

Das Denken in Risikoszenarien sensibilisiert für Fehlerketten in unternehmerischen Prozessen und hilft daher, Reaktionsmöglichkeiten vorzubereiten und so die Überlebenswahrscheinlichkeit in Extremsituationen zu erhöhen. Durch den konsequenten Einbezug von Experten aus allen Risikofeldern in den Risikomanagementprozess lässt sich die Illusion der Kontrolle und Kontrollierbarkeit aufbrechen. So lassen sich Flexibilisierungen beispielsweise der Supply Chain in den Managementprozess auf Grund komplexer Störungen durch Extremereignisse oder Business-Continuity-Pläne auf Basis von Risikoszenarien entwickeln (siehe Abb. 01).

Risikoszenarien können beispielsweise makroökonomische, politische und finanzielle Krisenereignisse reflektieren. Einen Ansatz zur Quantifizierung von Risikoszenarien, die existenzbedrohende unerwartete Ereignisse inkludieren, liefert die Extremwerttheorie [Einen Überblick zur Extremwerttheorie findet man beispielsweise in de Haan/Ferreira 2006]. Diese beschreibt im Gegensatz zum zentralen Grenzwertsatz das extreme Verhalten einer Zeitreihe, dass heißt die Ausreißer, die im Risikomanagement auch "schwarze Schwäne" genannt werden.

Abb. 01: Im Krisenfall stellt ein standardisiertes Vorgehen analog zu Einsatzplänen im Katastrophenschutz eine konzertierte Aktion auf Konzernebne sicher

Extremwerttheorie

Schwarze Schwäne treten häufiger auf, als uns Wahrscheinlichkeiten glauben lassen [vgl. Taleb 2008]. Beispiele für positive Extremereignisse sind herausragende technische Errungenschaften, wie die Erfindung der Eisenbahn, des Telefons oder des Computers oder medizinische Entdeckungen, wie beispielsweise die des Penicillins oder der Röntgenstrahlen. Für das Risikomanagement bedeutsamer sind negative Extremereignisse wie Terroranschläge (9/11, Paris 2015), Naturkatastrophen (Elbhochwasser 2002, Wintersturm Kyrill 2007), spektakuläre Pleiten großer Unternehmen (Philip Holzmann, Schlecker, Arcandor) oder Börsencrashs (Black Monday, China August 2015 und Januar 2016). Dass sich derartige Ereignisse nicht auf Basis vergangenheitsbasierter Modelle prognostizieren lassen, liegt auf der Hand: Daten sind unvollständig und Beobachtungszeiträume kurz, menschliches Handeln, welches die Ereignisse massiv beeinflusst, lässt sich nicht realistisch abbilden.

Wie können extreme Daten, beispielsweise mögliche Auswirkungen eines Börsencrashs oder der plötzliche Ausfall eines in der Vergangenheit immer zuverlässigen Lieferanten, bestimmt werden? Viele Fragen aus dem echten Leben erfordern Schätzungen. Wenn es keine Daten oder nur sehr wenige Beobachtungen gibt, werden wichtige Schätzungen öfter nach "Gefühl" als auf Grund von Tatsachen gemacht.

Extreme sind per definitionem ungewöhnliche und/oder seltene Ereignisse. Bei klassischen Datenanalysen werden diese als Ausreißer verharmlost oder gar ignoriert. Damit werden die reellen Daten manipuliert, um gut zu einem Modell zu passen. Extreme Daten dürfen ignoriert werden, wenn man nur Schätzungen alltäglicher Ereignisse benötigt. Betrachtet man Situationen, in denen das Meiste zu gewinnen oder zu verlieren ist, sind die Extremwerte keine zu ignorierende Ausnahme sondern die zu berücksichtigende "Regel".

Die Extremwerttheorie liefert einen wissenschaftlichen Ansatz zur Vorhersage der Größe von seltenen Ereignissen. Sie ist eine mathematische Disziplin, die sich mit Ausreißern, das heißt maximalen und minimalen Werten von Stichproben, beschäftigt. Diese Ausreißer unterliegen einem stochastischen Einfluss. Ein zentrales Resultat der Extremwerttheorie ist die Tatsache, dass für das Maximum (beziehungsweise das Minimum) einer Stichprobe – und hier ist es nahezu egal welche Verteilung zu Grunde liegt – im Wesentlichen nur drei Grenzverteilungen möglich sind. Diese sind die Gumbel-, Frechet- und Weibull-Verteilung. Die Verteilungen der Extremwerte bestimmter Risiken kann man bestenfalls modellieren, aber zumindest kann man mögliche Extremalwerte im unternehmerischen Planungsprozess berücksichtigen. Eine Einschätzung von Risiken mit Hilfe von Extremwertbetrachtungen ist für eine Vielzahl an Risiken möglich, insbesondere

- Markt- und Kreditrisiken,

- Operationelle Risiken (unter anderem zählen hierzu Supply-Chain-Risiken),

- Versicherungs- und Rückversicherungsrisiken.

Von all diesen Risiken ist bekannt, dass sie – sofern überhaupt ausreichende Zeitreihen vorliegen – nicht unabhängig und identisch verteilt sind. Sie besitzen die oben genannten "fat tails", ihre Volatilitäten verändern sich im Laufe der Zeit und über weite Bereiche sind die Daten nahezu unkorreliert aber nicht unabhängig. Das heißt die Methoden der klassischen Statistik sind definitiv nicht anwendbar.

Das Wunder von Belo Horizonte konnte nicht geschehen. Oder doch?

Das 7:1 im WM Halbfinale 2014 in Belo Horizonte hatte niemand auf dem Zettel, ein derart hoher Sieg Deutschlands war bei fast allen Buchmachern nicht tippbar [vgl. Süddeutsche Zeitung 2014]. Extremereignisse können auch glückliche und positive Überraschungen hervorbringen. Vor dem Weltmeisterschaftsspiel war man zu 65 Prozent davon ausgegangen, dass Brasilien gewinnt.

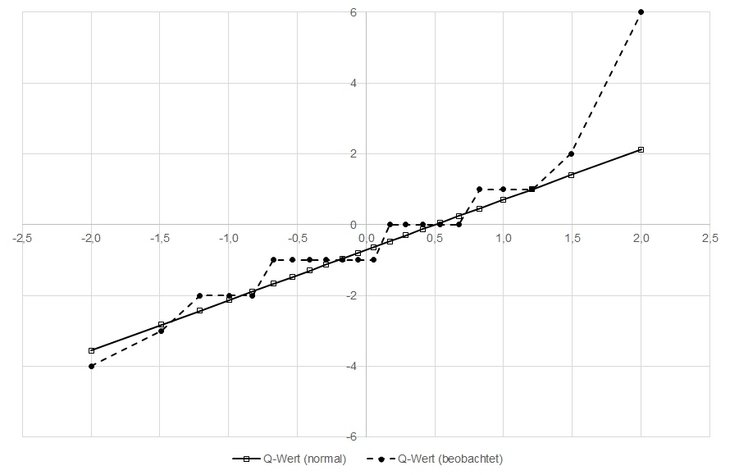

Insgesamt hat es 22 Länderspiele der deutschen Fußball-Nationalmannschaft gegen Brasilien geben [siehe www.fussballdaten.de/vereine/deutschland/brasilien/]. Schaut man sich die historischen Ergebnisse bis zum WM Halbfinalspiel 2014 an, so lassen sich die Ergebnisse näherungsweise durch eine Normalverteilung darstellen (siehe Abb. 02). Bei den 21 Begegnungen ergibt sich eine Mittelwert von -0,71 und eine Standardabweichung von 1,42 Toren. Würde man daraus eine Wahrscheinlichkeit ableiten, dass Deutschland mit sechs Toren Differenz gewinnt, so läge diese bei 0,01 Prozent. Dass das 22. Spiel mit einem solchen "historischen" Ergebnis endete, lässt sich durch die Normalverteilung auf Basis der historischen Daten nicht erklären (siehe Ausreißer im Q-Q-Plot in Abb. 02). Wendet man jedoch die Ergebnisse der Extremwerttheorie an und simuliert die Verteilung des Extremwertes der zu Grunde liegenden Verteilung, so ergibt sich, dass dieser mit 95%-iger Wahrscheinlichkeit nicht kleiner als 6,22 Tore ist. Das Ergebnis wurde mit Hilfe der Vose-Software ModelRisk simuliert. Natürlich ergibt sich auch ein für Fussball-Fans nicht so erfreulicher extremaler Verlust. Dieser liegt mit 95%-iger Wahrscheinlichkeit bei einer Tordifferenz von 6,41 Toren für Brasilien.

Das Beispiel zeigt, dass die Wahrscheinlichkeit des Ereignisses basierend auf historischen Beobachtungen sehr gering ist, dass es aber durchaus möglich ist, dass sich dieses Extremereignis realisiert.

Ähnliche Fragestellungen ergeben sich in zahlreichen Situationen: Wetterphänomene wie der wärmste oder kälteste Tag, die stärkste Windböe, die größte Niederschlagsmenge, Logistikprobleme wie das größte Verkehrsaufkommen, der längste Stau, finanzielle Risiken wie der größte Verlust oder der größte Betrug etc. Bei all den Beispielen muss man nicht notwendigerweise wissen, wann das Ereignis eintrifft, aber man kann bestimmen, wie groß die Auswirkungen maximal sein können.

Laut Süddeutscher Zeitung hatte ein Engländer auf das richtige Ergebnis des Spiels von Belo Horizonte gewettet und bei einem Wetteinsatz von fünf Pfund einen Gewinn von 2.500 Pfund ausbezahlt bekommen – ein Extremereignis.

Abb. 02: In dem Q-Q-Plot sind die Quantile der beobachteten Verteilung der Tordifferenz aller Länderspiele zwischen Deutschland und Brasilien (positive Werte bedeuten einen Sieg für Deutschland) den Quantilen der Normalverteilung gegenüber gestellt. Bis auf den Sieg mit sechs Toren Differenz im WM Halbfinale 2014 sieht man, dass die die empirischen Werte nahezu normal verteilt sind.

Fazit: Das dicke Ende kommt

Erstaunlich viele Daten aus dem echten Leben genügen der Normalverteilung oder verwandter Verteilungen, die sehr gut verstanden sind und leicht berechnet werden können. Wenn man jedoch an den Enden der Verteilungen einen Blick auf die extremen Werte wirft, fällt auf, dass diese Enden dicker sind als von den klassischen Verteilungen vorhergesagt ("fat tail"). Im Risikomanagement muss man daher nicht nur die "normalen" Risiken betrachten – hier liefern klassische Risikomaße wie der Value-at-Risk gute Ergebnisse – sondern man muss sich auf das Unbekannte und Seltene vorbereiten. Hierzu wird Dennis Weatherstone, der CEO von J.P. Morgan, der den Value-at-Risk eingeführt hat, folgendermaßen zitiert: VaR gets me to 95% confidence. I pay my Risk Managers good salaries to look after the remaining 5% [vgl. RiskMetrics Group 1999].

Das Problem der Modellierung seltener Phänomene ist, das diese fast immer außerhalb des Bereichs der vorhandenen Beobachtungen liegen. Das Denken in Risikoszenarien und die Bewertung von Risiken mit Hilfe der Extremwerttheorie liefern hier Ergänzungen zum klassischen Ansatz der Expertenschätzung und des "Ratens".

Die Analyse von Geschäftsprozessen in Risikoszenarien hilft dem Unternehmen kleine, alltägliche Fehler aufzuspüren und vereinfachenden Diagnosen zu widerstehen, die sich irgendwann durch eine Verkettung zu schwerwiegenden Problemen entwickeln könnten. Dadurch wird die Sensibilität für betriebliche Abläufe geschärft, Entscheidungsprozesse werden flexibilisiert und Expertenwissen wird in Entscheidungsprozesse und Notfallpläne integriert.

Für Unternehmen ist das Denken in Risikoszenarien ein Umstellungsprozess, bedeutet es doch, dass man auf die Annehmlichkeiten verzichten muss, sich an Vereinfachungen, strategischen Plänen und organisatorischen Hierarchien zu orientieren.

Lernen kann man hier von Organisationen, die regelmäßig für Spitzenleistungen sorgen, weil sie in Umgebungen arbeiten, in denen das Potenzial für Fehler und Katastrophen exorbitant hoch ist, wie beispielsweise medizinische Notfallteams oder die Flugsicherung. Diese Organisationen müssen unbedingt zuverlässig funktionieren. Sie gewährleisten dies, indem sie ihre Vorstellungen von den Ereignissen immer wieder auf den neuesten Stand bringen und sich nicht in "alten Denkkategorien" oder "unausgegorenen Deutungen der äußeren Bedingungen" verfangen [vgl. Weick/Sudcliffe 2010].

Extreme Risiken lassen sich mit Hilfe der Extremwerttheorie bewerten. Nicht nur in der Finanzwelt findet diese Theorie Anwendung. Auch beispielsweise Biotech-Analysen, die Untersuchung des Datentransfers im Internet und Supply-Chain-Analysen bieten sich für Extremwerttheorie-Anwendungen an, da hier die Datenverteilungen ebenfalls "fat tails" haben.

Das Denken in Risikoszenarien unter Einbeziehung der Extremwerttheorie beschränkt sich damit keinesfalls auf Unternehmen im Finanzbereich oder spezielle Organisationen, wie sie oben genannt wurden. Auch Unternehmen anderer Branchen sollten die Einsatzmöglichkeit überprüfen, denn auch ihre Risikomanager müssen sich Gedanken um Ereignisse machen, die mit geringer Wahrscheinlichkeit eintreten, aber zu katastrophalen Verlusten führen können. Und häufig sind bei mittelständischen Firmen die Kapitalposter zum Abdecken von Verlusten aus Extremrisiken dünn.

Quellenverzeichnis und weiterführende Literaturhinweise:

- de Haan, Laurens/Ferreira, Ana [2006]: Extreme Value Theory, Springer Verlag, Berlin u.a. 2006.

- European Banking Authority [2016]: Draft Guidelines on stress testing and supervisory stress testing, EBA/CP/2016/28.

- Gulati, Ranjay/Casto, Charles/Krontiris, Charlotte [2014]: Das andere Fukushima, in Harvard Business Manager, Oktober 2014, S. 53-59.

- Klasen, Oliver [2014]: Statistisch unglaublich, in: Süddeutsche Zeitung, 9. Juli 2014.

- RiskMetrics Group [1999]: Risk Management: A Practical Guide, 1999.

- Taleb, Nassim Nicholas [2008]: Der Schwarze Schwan: Die Macht höchst unwahrscheinlicher Ereignisse, Hanser Verlag, München 2008.

- Thun, Christian/Prioux, Sandrine/Canamero, Maria C. [2013]: Stress Testing Best Practices: A Seven Step Model, in Moody’s Analytics Risk Perspectives: Stress Testing European Edition Vol. 1, September 2013.

- Weick, Karl. E./Sudcliffe, Kathleen M. [2010]: Das Unerwartete Managen: Wie Unternehmen aus Extremsituationen lernen, Schäffer-Poeschel Verlag, Stuttgart 2010.

Autor:

Prof. Dr. Thomas Schauerte, Hochschule Coburg